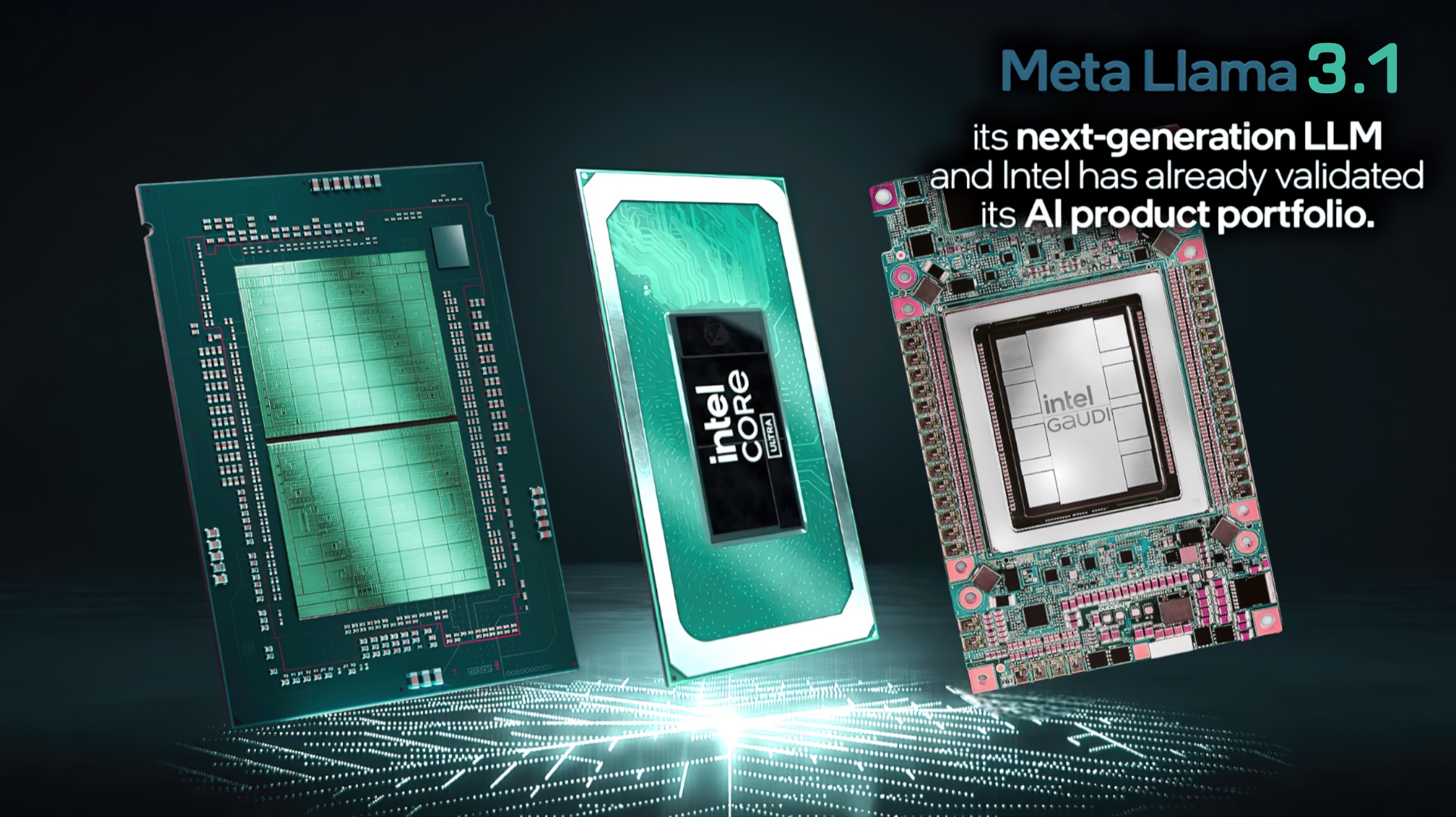

اینتل بهینهسازیهایی را برای Llama 3.1 برای افزایش عملکرد در همه محصولات: Gaudi، Xeon، Core و Arc اعلام کرد.

Llama 3.1 متا اکنون فعال است و اینتل دارای اعلام کرد پشتیبانی کامل از مدل های هوش مصنوعی Llama 3.1 در کل مجموعه خود مانند Gaudi، Xeon، Arc و Core.

همه پردازندهها و پردازندههای گرافیکی اینتل اکنون با مدلهای هوش مصنوعی Llama 3.1 عملکرد بهتری دارند

متا به تازگی جدیدترین مدل زبان بزرگ Llama 3.1 امروز، که لاما نسخه 3 در آوریل منتشر شد. با آن، اینتل اعداد عملکرد Llama 3.1 را در آخرین محصولات خود، از جمله رایانه های شخصی Intel Gaudi، Xeon و AI مبتنی بر پردازنده های Core Ultra و گرافیک Arc منتشر کرد. اینتل به طور مداوم بر روی اکوسیستم نرمافزار هوش مصنوعی خود کار میکند و مدلهای جدید Llama 3.1 بر روی محصولات هوش مصنوعی آن که با چارچوبهای مختلفی مانند PyTorch و Intel Extension برای PyTorch، DeepSpeed، Hugging Face Optimum Libraries و vLLM در دسترس هستند، فعال میشوند تا اطمینان حاصل شود که کاربران عملکرد بهتری دارند. در مرکز داده، لبه و محصولات هوش مصنوعی مشتری برای جدیدترین Meta LLM.

Llama 3.1 از مجموعه LLMهای چندزبانه تشکیل شده است که مدل های تولیدی از پیش آموزش دیده و تنظیم شده با دستورالعمل را در اندازه های مختلف ارائه می دهد. بزرگترین مدل پایه معرفی شده در Llama 3.1 اندازه 405B است که قابلیت های پیشرفته ای را در دانش عمومی، هدایت پذیری، ریاضیات، استفاده از ابزار و ترجمه چند زبانه ارائه می دهد. مدلهای کوچکتر شامل اندازههای 70B و 8B هستند که اولی یک مدل بسیار کارآمد و در عین حال مقرونبهصرفه است و دومی یک مدل سبک وزن برای پاسخدهی فوقالعاده سریع است.

اینتل Llama 3.1 405B را روی شتابدهندههای Intel Gaudi خود، که پردازندههای ویژهای برای آموزش و استنتاج مقرونبهصرفه و با کارایی بالا طراحی شدهاند، آزمایش کرد. نتایج نشان دهنده پاسخ سریع و توان عملیاتی بالا با طول توکن های مختلف است که قابلیت های شتاب دهنده های Gaudi 2 و نرم افزار Gaudi را نشان می دهد. به طور مشابه، گائودی 2 شتابدهندهها عملکرد سریعتری را در مدل 70B با طول توکنهای 32k و 128k نشان میدهند.

در مرحله بعد، پردازندههای Xeon Scalable نسل پنجم اینتل را روی میز آزمایش داریم که عملکرد را با طولهای توکن مختلف نشان میدهند. با ورودی های توکن 1K، 2K و 8K، تأخیر توکن در هر دو تست BF16 و WOQ INT8 در یک محدوده نزدیک است (عمدتاً زیر 40 میلی ثانیه و 30 میلی ثانیه). این نشان دهنده واکنش سریع پردازنده های Xeon اینتل است که دارای Intel AMX (Advanced Matrix Extensions) برای عملکرد برتر هوش مصنوعی هستند. حتی با 128 هزار ورودی توکن، تأخیر در هر دو تست زیر 100 میلیثانیه باقی میماند.

استنتاج Llama 3.1 8B در پردازندههای Intel Core Ultra بسیار سریع است و همچنین هنگام آزمایش بر روی مدل 8B-Instruct 4-bit Weights. همانطور که در Core Ultra 7 165H با گرافیک داخلی Arc آزمایش شد، تاخیر توکن بین 50 میلیثانیه تا 60 میلیثانیه با ورودیهای 32، 256، 512 و 1024 توکن باقی میماند. در یک پردازنده گرافیکی Arc مجزا مانند Arc A770 16GB Limited Edition، تأخیر بسیار کم است و با هر چهار اندازه ورودی نشانه متفاوت، حدود 15 میلیثانیه باقی میماند.