NVIDIA صحبت می کند که چگونه هوش مصنوعی محاسبات گرافیکی را در پردازنده های گرافیکی مصرف کننده تغییر می دهد: تبدیل پیکسل ها به درک بصری

انویدیا با پردازندههای گرافیکی خود در ارائه مهارتهای هوش مصنوعی به مصرفکنندگان پیشرو بوده است و چندین فناوری جدید در راه هستند که در سالهای آینده عصر جدیدی از بازی و وفاداری گرافیکی را آغاز خواهند کرد.

DLSS 3.5 و بازسازی اشعه انویدیا تازه شروع است، شرکت در مورد چندین فناوری هوش مصنوعی نسل بعدی صحبت میکند که اساساً نحوه تولید پیکسلها توسط پردازندههای گرافیکی مصرفکننده را تغییر میدهند

هجوم هوش مصنوعی به هر برنامه اصلی شناخته شده برای جهان بشر قریبالوقوع به نظر میرسد، با توجه به اینکه غولهای فناوری بزرگ مانند مایکروسافت و آمازون درگیر مسابقه ادغام هوش مصنوعی هستند، صرفاً به دلیل مزایای عظیم فناوری، چه در قالب محاسبات پیشرفته باشد، چه حتی در بهبود تجربه مصرف کننده، به ارمغان می آورد.

با این حال، NVIDIA در استفاده از هوش مصنوعی در برنامههای محاسباتی و سازمانی در صدر قرار دارد، یک مثال قابل توجه ACE’s NVIDIA. این شرکت اکنون مصمم به استفاده از قدرت هوش مصنوعی برای بهبود عملکرد گرافیکی است. این پست یک خبر اصلی نیست، بلکه روایتی از زنجیره ای از رویدادها است که نشان می دهد هوش مصنوعی چقدر نقش مهمی در عملکرد گرافیکی پردازنده های گرافیکی ما ایفا می کند و در نهایت راه های جدیدی را در راه تجسم ایده های خود به صورت گرافیکی توسط توسعه دهندگان باز می کند. “

بازسازی پرتوهای NVIDIA: ترکیب RT و AI در یک بسته واحد برای بهبود چشمگیر تصاویر

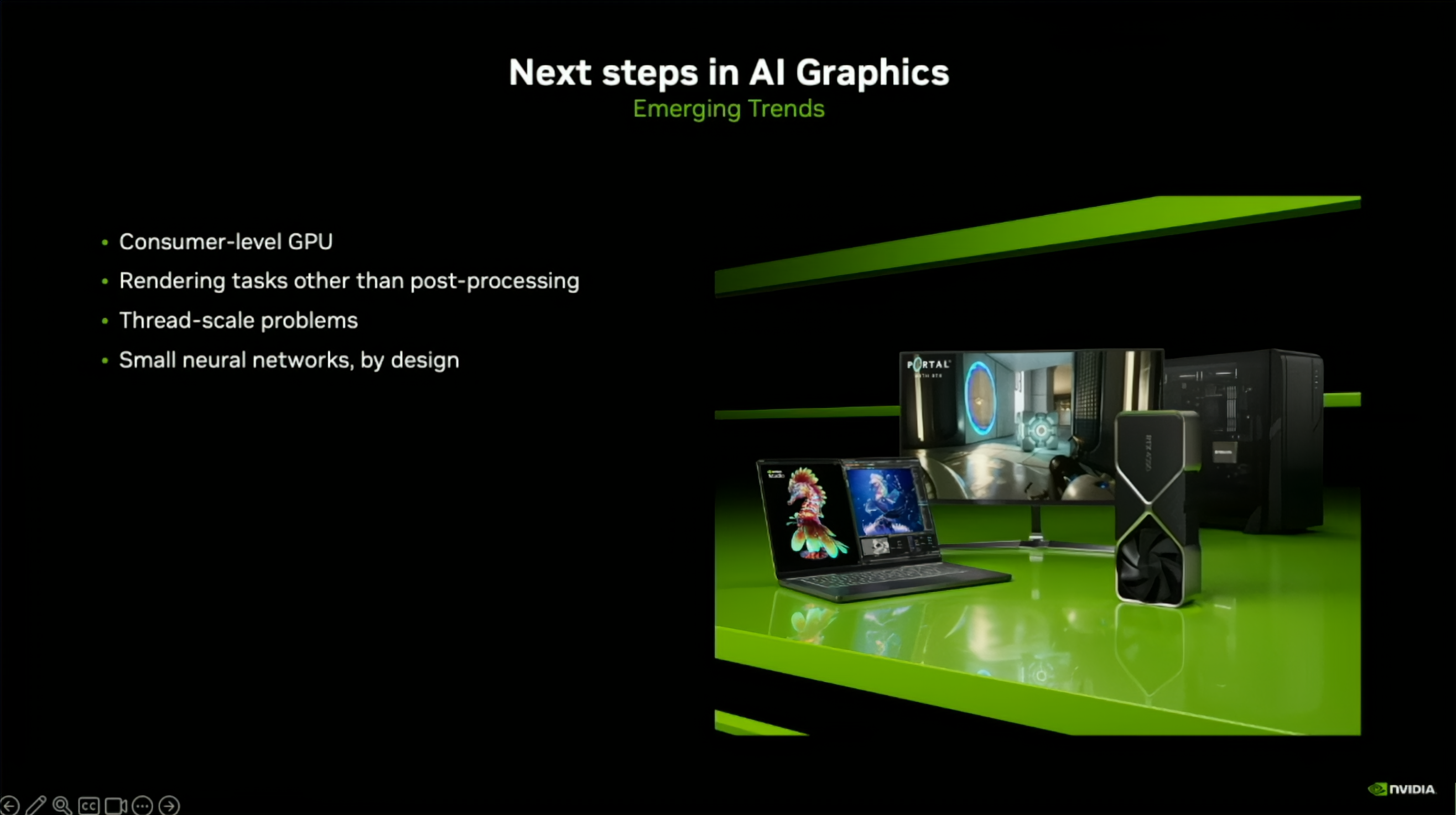

در عصر مدرن گرافیک، رقابت در این است که چگونه معماری میتواند وضوحهای بومی را ارتقاء دهد، و به مصرفکنندگان اجازه میدهد بهترین سناریوها را از طریق ابزارهای “با سوخت مصنوعی” مشاهده کنند، مانند DLSS NVIDIA و FSR AMD. NVIDIA میگوید که با هجوم هوش مصنوعی، آنها موفق شدهاند پیکسلهای «۷ به ۸» را که به کاربران نمایش داده میشوند، افزایش دهند و در برخی موارد وضوح را به طور بالقوه «چهار برابر» کنند. از این طریق، این شرکت توانسته است به توسعه دهندگان اجازه دهد تا عناوین قدیمی تر را با تقویت قدرت DLSS، “بازآفرینی” کنند.

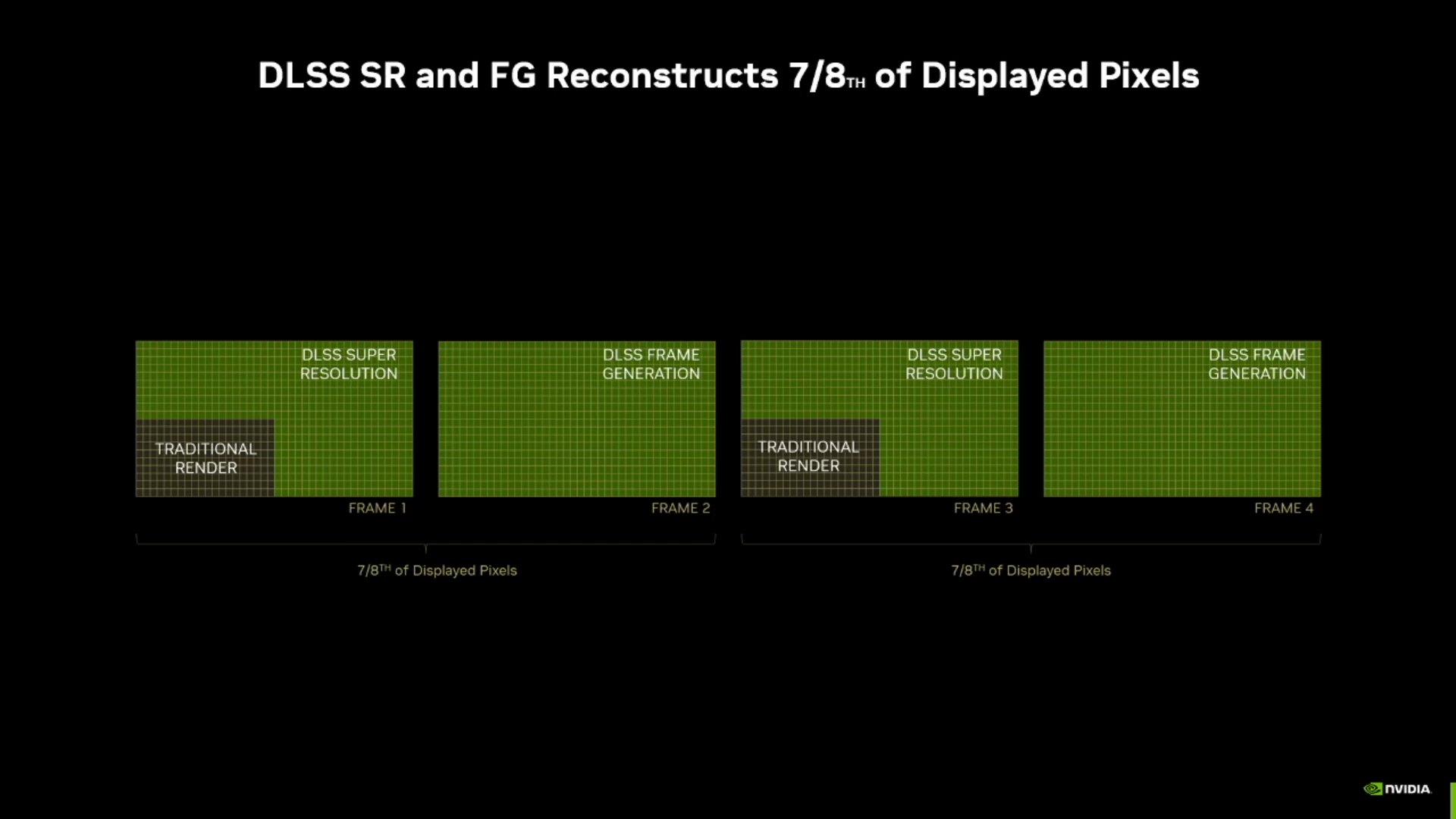

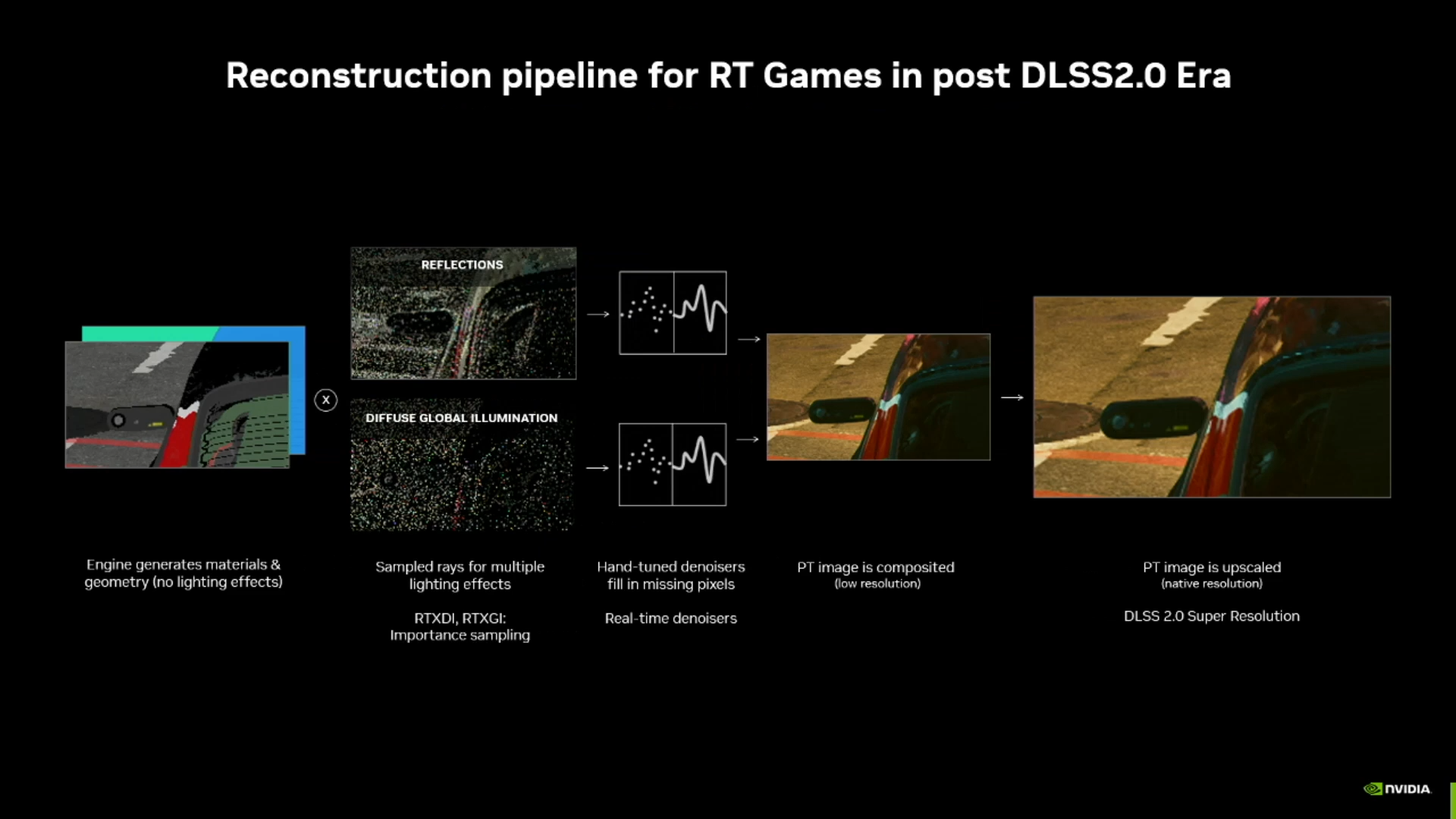

برای بررسی کمی پسزمینه، خطوط لوله ردیابی پرتوهای قبلی NVIDIA به چندین عنصر، از حذفکنندهها (که برای پاک کردن مصنوعات نویز استفاده میشوند) تا فیلتر ضد آلیاسینگ، برای رسیدن به نتیجهای که با آن دیدیم، وابسته بودند. فناوریهایی مانند DLSS 2. اگرچه این کار را انجام داد، اما به توسعهدهندگان اجازه نمیداد از مزایای «افزایش تصویر» استفاده کنند، زیرا خط لوله نمیتوانست آن را به زبان ساده پشتیبانی کند، اگرچه پیچیدگی زیادی در این بیانیه وجود دارد. .

بنابراین، حرکت رو به جلو، ادغام ارتقاء تصویر ضروری بود، و برای انجام این کار، NVIDIA تصمیم گرفت “بازسازی پرتو.” این مکانیسم خاص نحوه برخورد با خطوط لوله ردیابی پرتو را تغییر داد و به جای آن، یک رویکرد “حذف کننده واحد” اتخاذ شد. Ray Reconstruction از چندین مدل هوش مصنوعی استفاده میکند که برای کنترل سیگنالهای بسیار پویا، مانند سایههای متحرک، منابع نور، و اشیاء طراحی شدهاند و در عوض، عملکردی را ارائه میکند که در مقایسه با حذفکنندههای دست ساز به طور قابل توجهی بهبود یافته است.

بازسازی پرتو پیشرفت عظیمی در حوزه گرافیکهای مبتنی بر هوش مصنوعی خواهد بود، زیرا فرآیند ردیابی پرتو را بهینه میکند، آن را برای هر مصرفکنندهای در دسترس قرار میدهد و حتی محدودیتهای سختافزاری را در برخی موارد حذف میکند. نه تنها این، بلکه مرزهای محاسبات گرافیکی را نیز حذف کرده است، و به توسعه دهندگان این امکان را می دهد تا تصاویری خیره کننده ارائه دهند و حتی عناوین کلاسیک را بازسازی کنند تا از “انتقال گرافیکی” آنها به عصر مدرن اطمینان حاصل کنند.

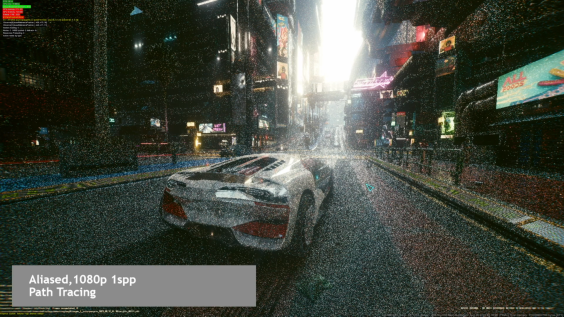

مراحل بعدی انویدیا در گرافیک هوش مصنوعی

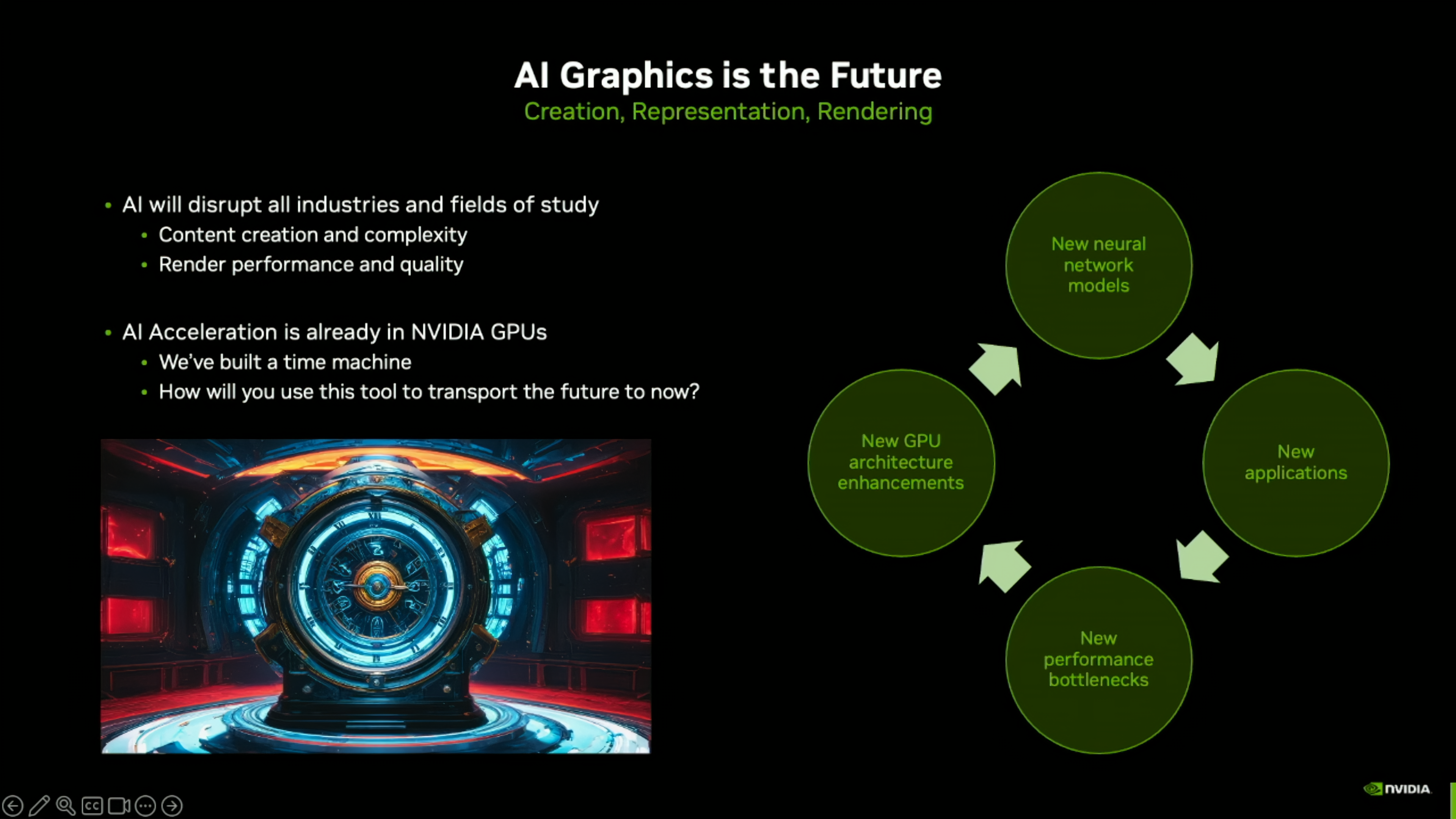

اما بعد چه می شود؟ جان برگس از NVIDIA اخیراً برخی از گرایشهای نوظهور گرافیک هوش مصنوعی را در جریان رویداد گرافیکی با عملکرد بالا برجسته کرد و به طور خاص در مورد پردازندههای گرافیکی سطح مصرفکننده مانند RTX برای GeForce و RTX برای ایستگاههای کاری صحبت کرد. ذکر شده است که هوش مصنوعی می تواند در کارهای مختلف رندر غیر از پردازش پس از پردازش مانند DLSS کمک کند. این چیزی است که همچنین که توسط TAP اینتل اشاره شده است که کاربرد هوش مصنوعی را فراتر از ارتقاء مقیاس و تولید فریم می بیند. نمونهای از آن نیز توسط NVIDIA در همان رویداد نشان داده شد که در ادامه به آن خواهیم پرداخت.

برخی از رویکردهای جدید ارائه شده توسط NVIDIA عبارتند از:

NVIDIA حافظه پنهان و عملکرد را با فشردهسازی بافت عصبی، مدلهای کش نورالویدیبی و حافظه پنهان درخشندگی عصبی افزایش میدهد

نخستین نمونه استفاده از هوش مصنوعی برای افزایش وفاداری گرافیکی، فشرده سازی بافت عصبی است که از یک MLP کوچک (پرسپترون چند لایه) استفاده می کند که یک شبکه عصبی مصنوعی متشکل از نورون های متصل است. مدل فشرده سازی بافت عصبی از 1 شبکه MLP در هر پشته بافت مواد استفاده می کند و شامل 2 لایه پنهان است.

این مدل امکان افزایش فشرده سازی 4-16 برابری را بر روی بافت های فشرده بلوک استاندارد یا BC ها فراهم می کند. این اجازه می دهد تا بافت هایی با وضوح بالاتر در همان ردپای حافظه و وضوح معادل در حافظه بسیار کوچکتر وجود داشته باشد، و به GPU هایی با VRAM، پهنای باند و حافظه کش محدود اجازه می دهد تا بافت های با وضوح بالاتر را به طور موثرتری مدیریت کنند.

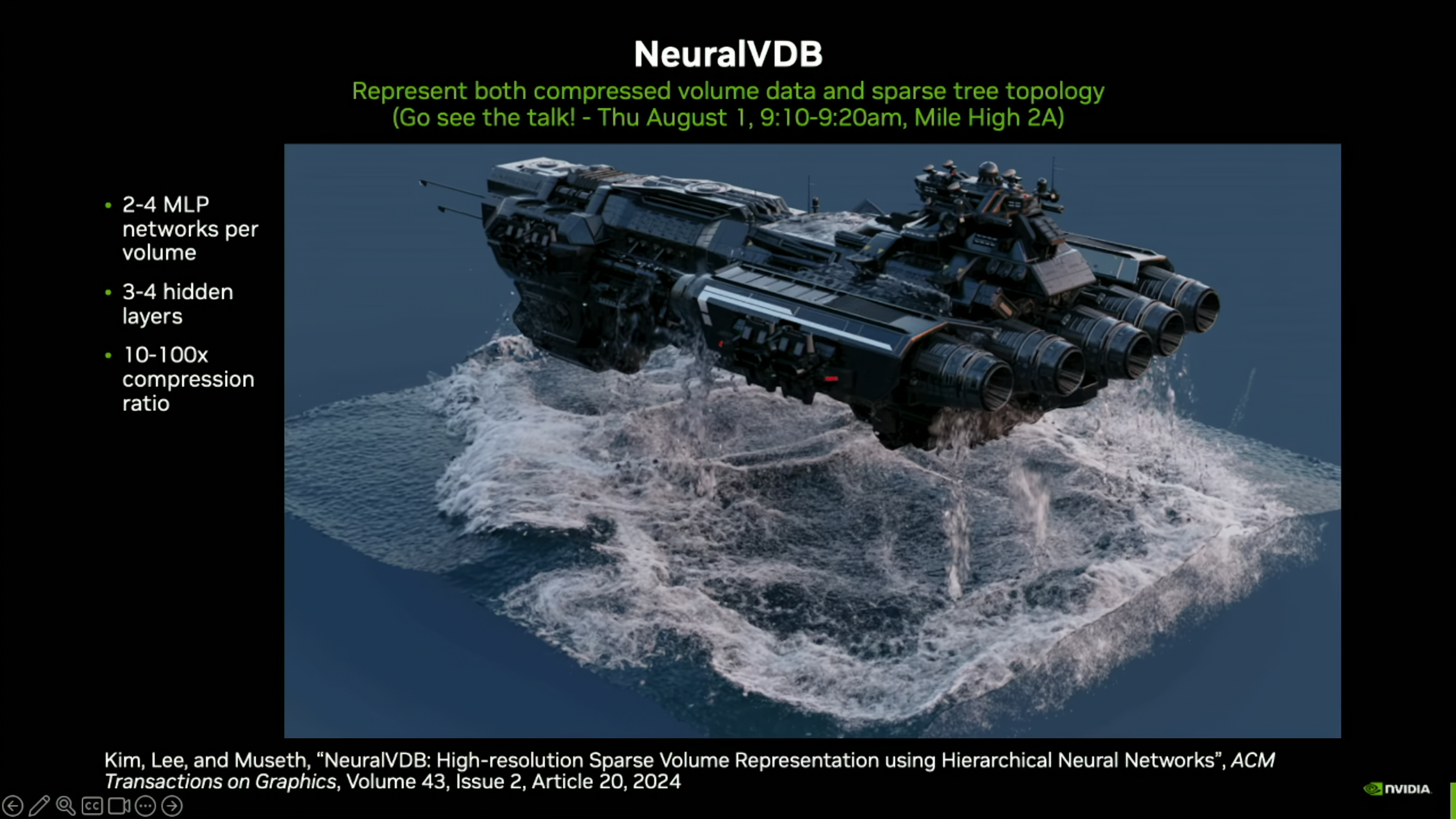

بعدی NeuralVDB است که داده های حجم فشرده و همچنین توپولوژی درخت پراکنده را نشان می دهد. از 2-4 MLP در هر حجم با 3-4 لایه پنهان استفاده می کند و نسبت فشرده سازی 10-100 برابر را به دست می آورد. در SIGGRAPH 2022، NVIDIA نشان داد که چگونه می توان از مدل برای اجرا استفاده کرد شبیه سازی حجمی پیچیده با کاهش ردپای حافظه تا 100 برابر.

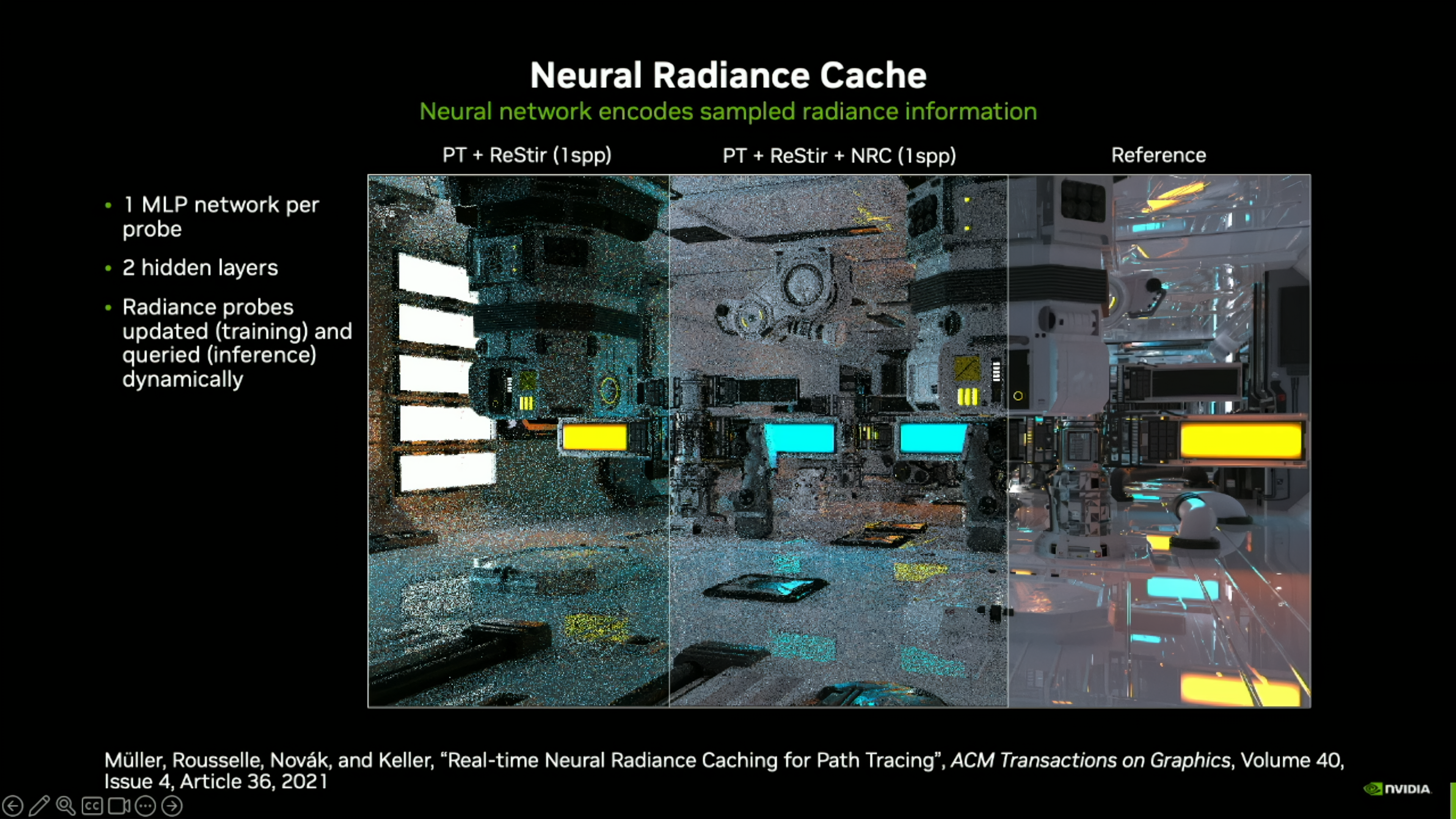

در نهایت، حافظه پنهان درخشندگی عصبی وجود دارد که از یک شبکه عصبی برای رمزگذاری اطلاعات تابشی استفاده می کند. این مدل از یک شبکه MLP منفرد در هر کاوشگر با 2 لایه پنهان استفاده می کند و می تواند به صورت پویا پروب ها (آموزش) و پرس و جو (استنتاج) را به روز کند. افزودن حافظه پنهان درخشندگی عصبی به رندر Path Tracing کیفیت نمونه را به طرز چشمگیری بهبود می بخشد. این به تبدیل سریعتر کمک میکند یا میتواند حذف نویز رندر را آسانتر کند.

برنامه های انویدیا برای افزایش رندر زمان واقعی شامل استفاده از مدل های ظاهر عصبی است که پیشرفت های عظیمی را به همراه دارد

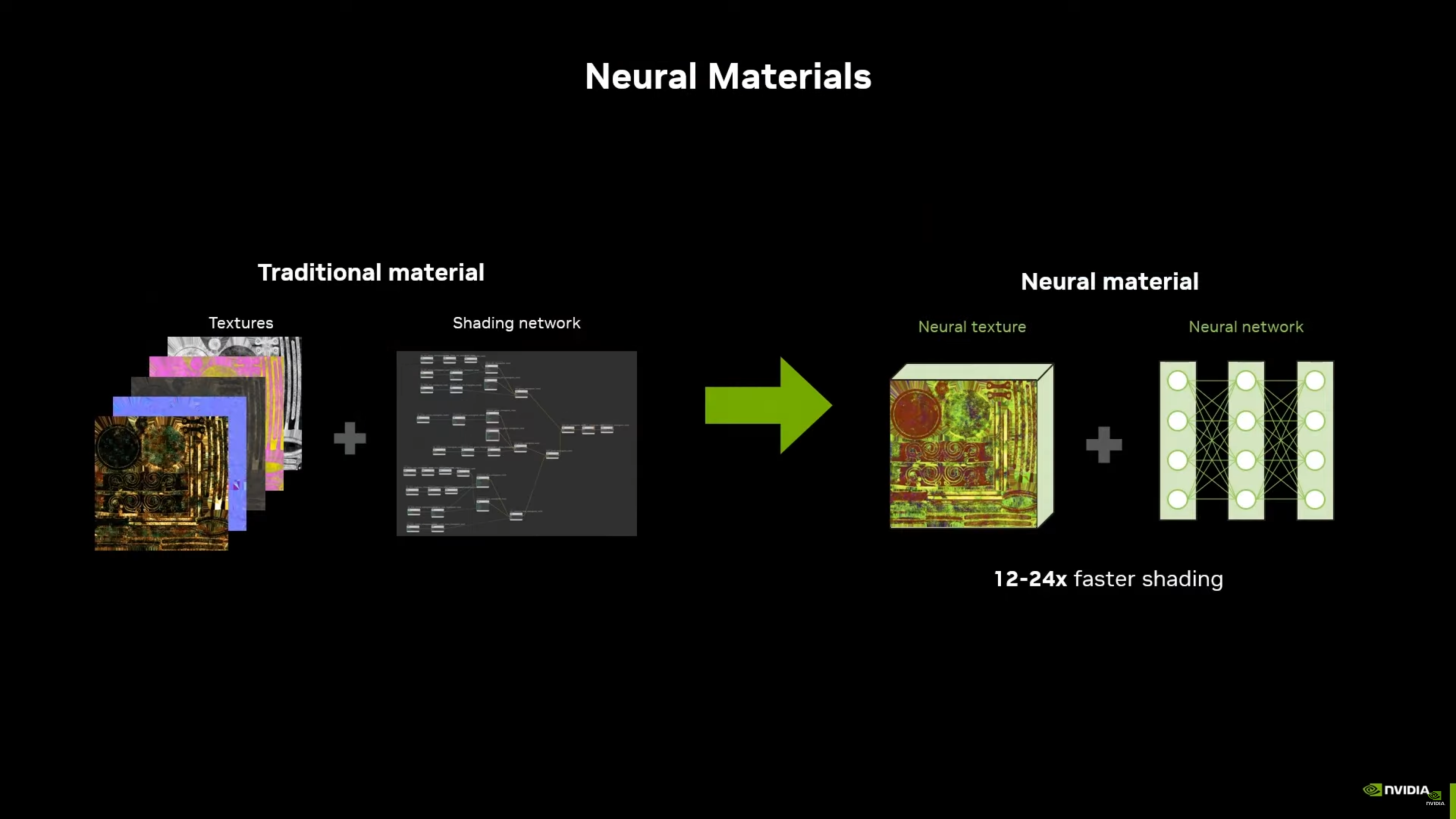

اکنون که از ردیابی پرتوی خارج شدهایم، بیایید کمی در مورد عملکرد سایهزنی و رندر بلادرنگ صحبت کنیم، که بلوکهای اصلی محاسبات گرافیکی هستند. NVIDIA روش بسیار جالبی برای مرتب کردن این بخش ارائه کرده است، و به عنوان که در پوشش قبلی مشخص شد، این شرکت از قابلیت های مدل های مواد عصبی استفاده کرده است که در ادامه توضیح خواهیم داد. در حال حاضر، تیم گرین موفق شده است شبکه های عصبی را به گونه ای چارچوب بندی کند که اکنون می توانند محاسبات گرافیکی را به سطوح جدیدی ارتقا دهند که هرگز تصور نمی شد.

در سخنرانی اصلی SIGGRAPH 2024، NVIDIA مدلهای ظاهر عصبی، مدلهای ظاهر عصبی را معرفی کرد. که از هوش مصنوعی برای نمایش و ارائه ظاهر مواد به شیوه ای واقعی تر از طریق روش هایی که به شدت از روش های سنتی بهینه شده اند استفاده می کنند. این مدلهای عصبی بهگونهای آموزش داده میشوند که ویژگیهای بصری مواد دنیای واقعی را بدانند، و با استفاده از چنین مجموعهای از دادهها در ارائه تصاویر، محصول نهایی را ایجاد میکنند که نه تنها بسیار واقعی است، بلکه بسیار سریعتر است.

شکل>

شکل>

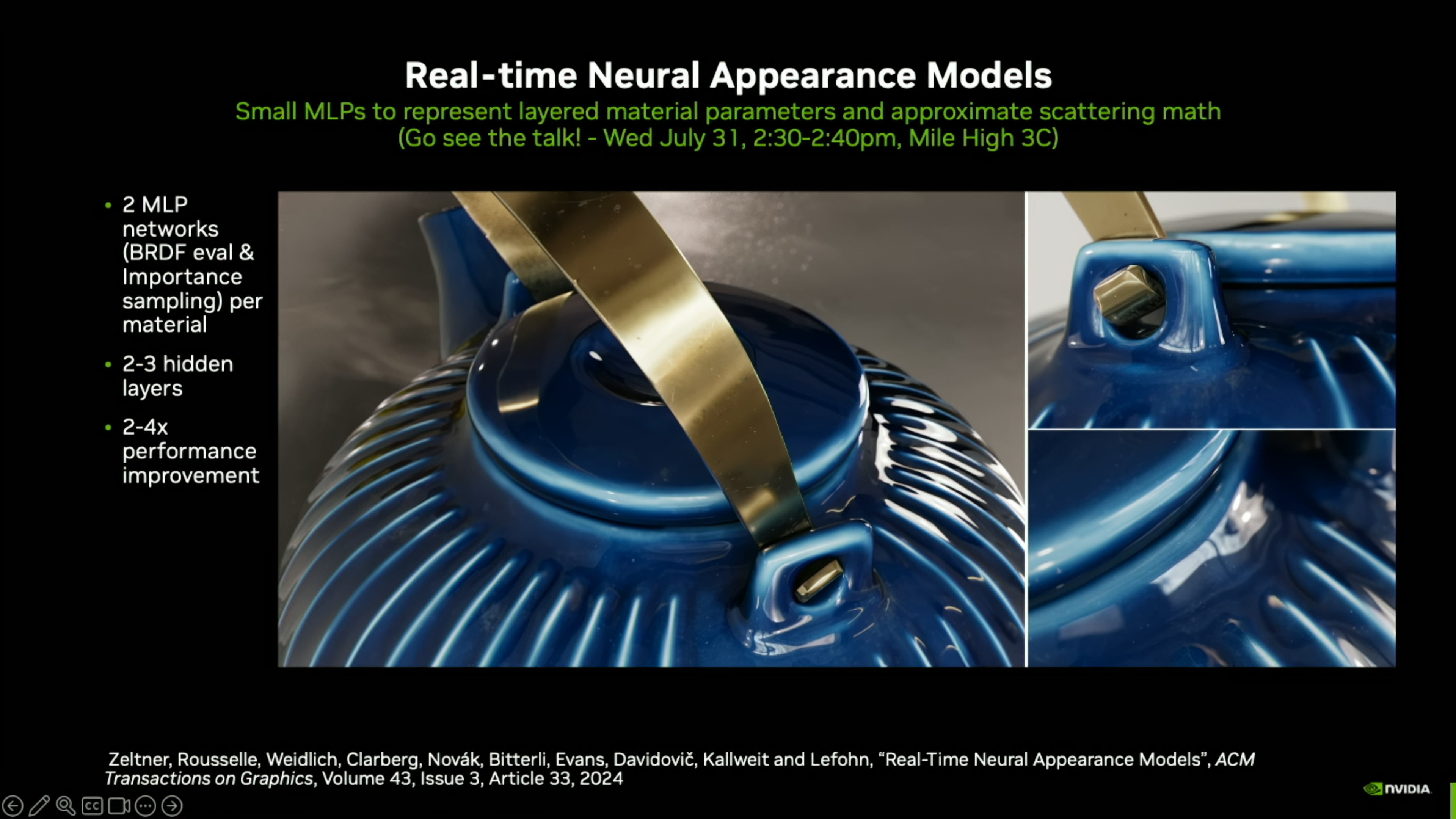

در حالی که توضیح پیچیدگی های شبکه های عصبی به اندازه کافی چالش برانگیز است، به خصوص برای یک خواننده معمولی، ما سعی خواهیم کرد موارد را به موثرترین روش خلاصه کنیم. ببینید، مدلهای ظاهر عصبی که قبلاً در مورد آنها صحبت کردیم، بر روی بلوکهای خاصی ساخته شدهاند، که شامل 2 MLP (پرسپترون چند لایه)، یکی برای ارزیابی BRDF و دیگری برای نمونهبرداری اهمیت و نمونهگیری داده است، اما تا سطح کاملاً جدیدی مقیاسبندی شدهاند. همراه با آن، NAM ها از معماری رمزگذار-رمزگشا استفاده می کنند که شامل پردازش داده های ورودی و تولید ظاهر نهایی مواد بر اساس پارامترها به همراه مجموعه داده است.

شکل>

شکل>

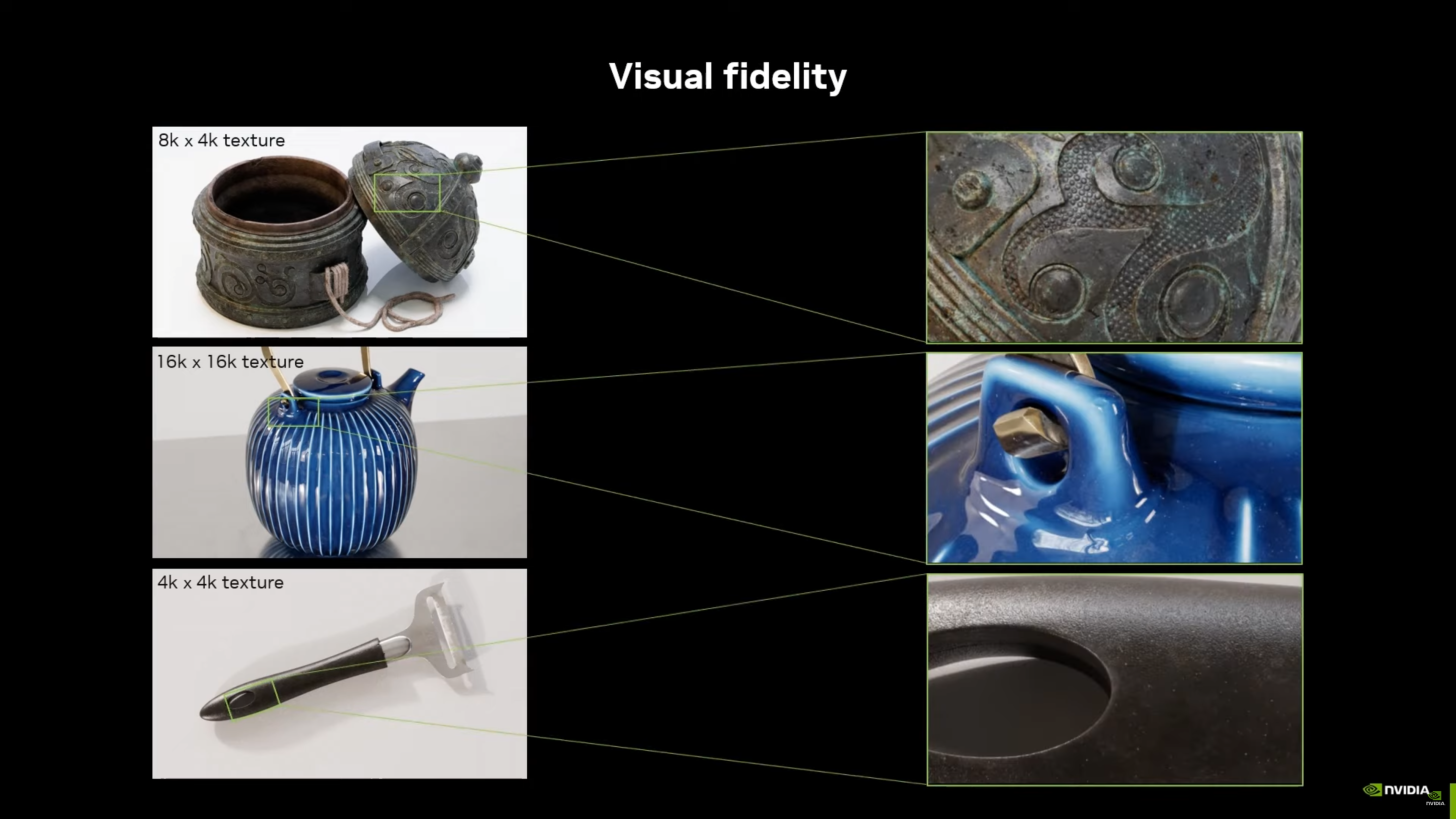

اکنون که ایده ای از نحوه عملکرد NAM ها دارید، بیایید به قسمت جالب آن برویم: قابلیت های بالقوه آنها. نمایشگاه NVIDIA از مدلهای ظاهر عصبی نشان داد که آنها قادر به ارائه وضوح بافت تا 16K هستند که یک جهش بزرگ است. جدا از این، گفته میشود که شبکههای عصبی کارآمد محاسباتی روی برد، زمانهای رندر را به میزان 12 تا 24 برابر کاهش میدهند، اما باز هم یک دستاورد عظیم است، با توجه به اینکه با تکنیک سنتی گراف سایهزنی، این امر غیرممکن تلقی میشد.

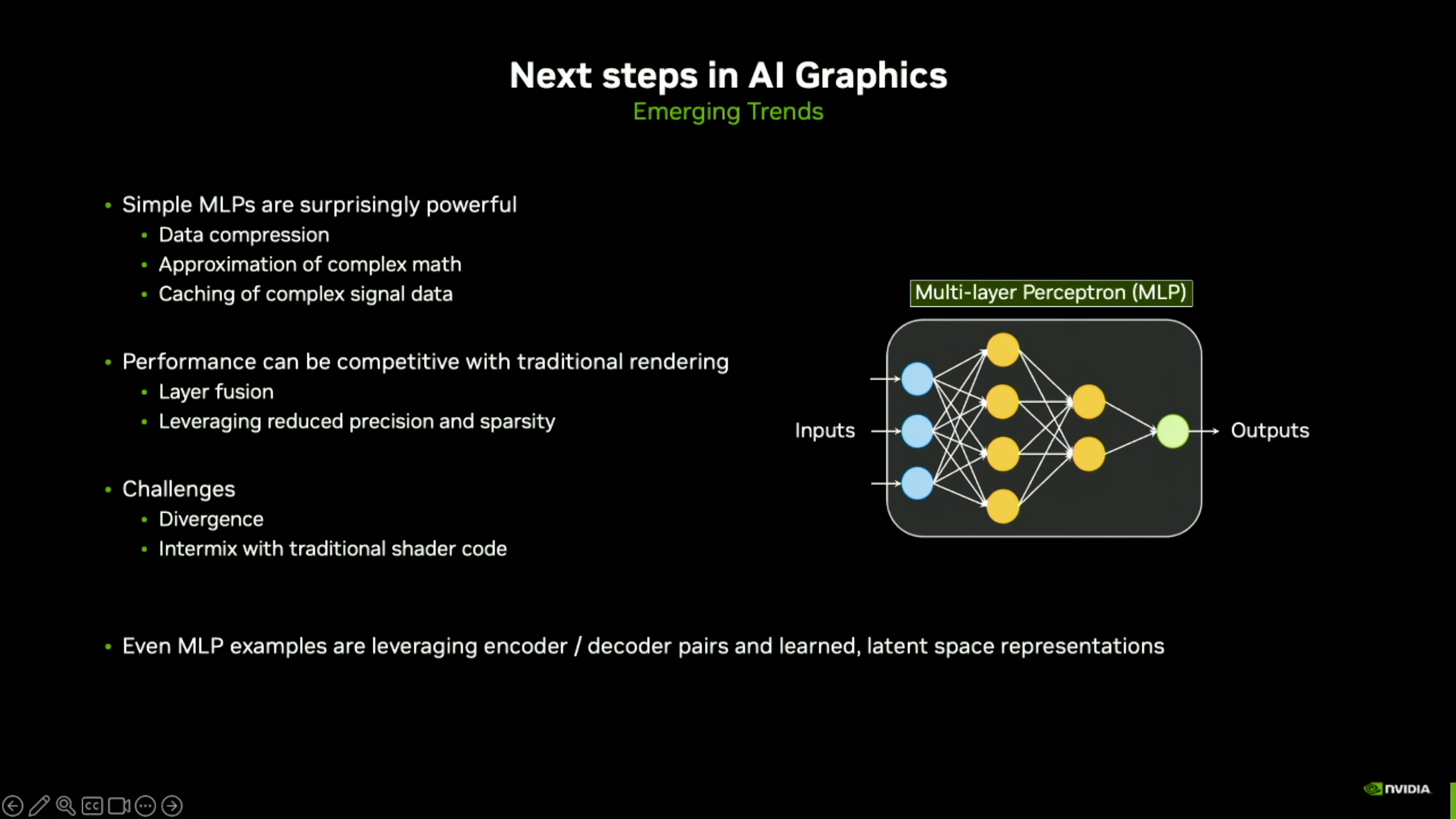

با نگاه به آینده، NVIDIA معتقد است که MLP ها و به طور کلی هوش مصنوعی می توانند به پیشرفت های بزرگی در دنیای گرافیک دست یابند:

MLP های ساده به طرز شگفت آوری قدرتمند هستند (برای):

- فشرده سازی داده

- تقریبا ریاضیات پیچیده

- ذخیره سازی داده های سیگنال پیچیده

عملکرد میتواند با رندر سنتی رقابتی باشد:

- همجوشی لایه

- استفاده از اهرم دقت و پراکندگی کمتر

از آنجایی که MLP ها کوچک هستند، عملکرد آنها می تواند با رندرهای سنتی رقابتی باشد، بنابراین این پیشرفت ها هزینه زیادی ندارند.

چالش ها:

- واگرایی

- اینترمیکس با هسته سایه زن سنتی

برخی چالشها شامل واگرایی است که اساساً میگوید اگر هر رشته در GPU شبکه عصبی خود را برای مقدار تکسل خود پرس و جو میکند/اجرا میکند، باید بر واگرایی غلبه کنند زیرا این رشتهها قرار است با هم کار کنند. بنابراین هم واگرایی اجرا و هم واگرایی داده وجود دارد.

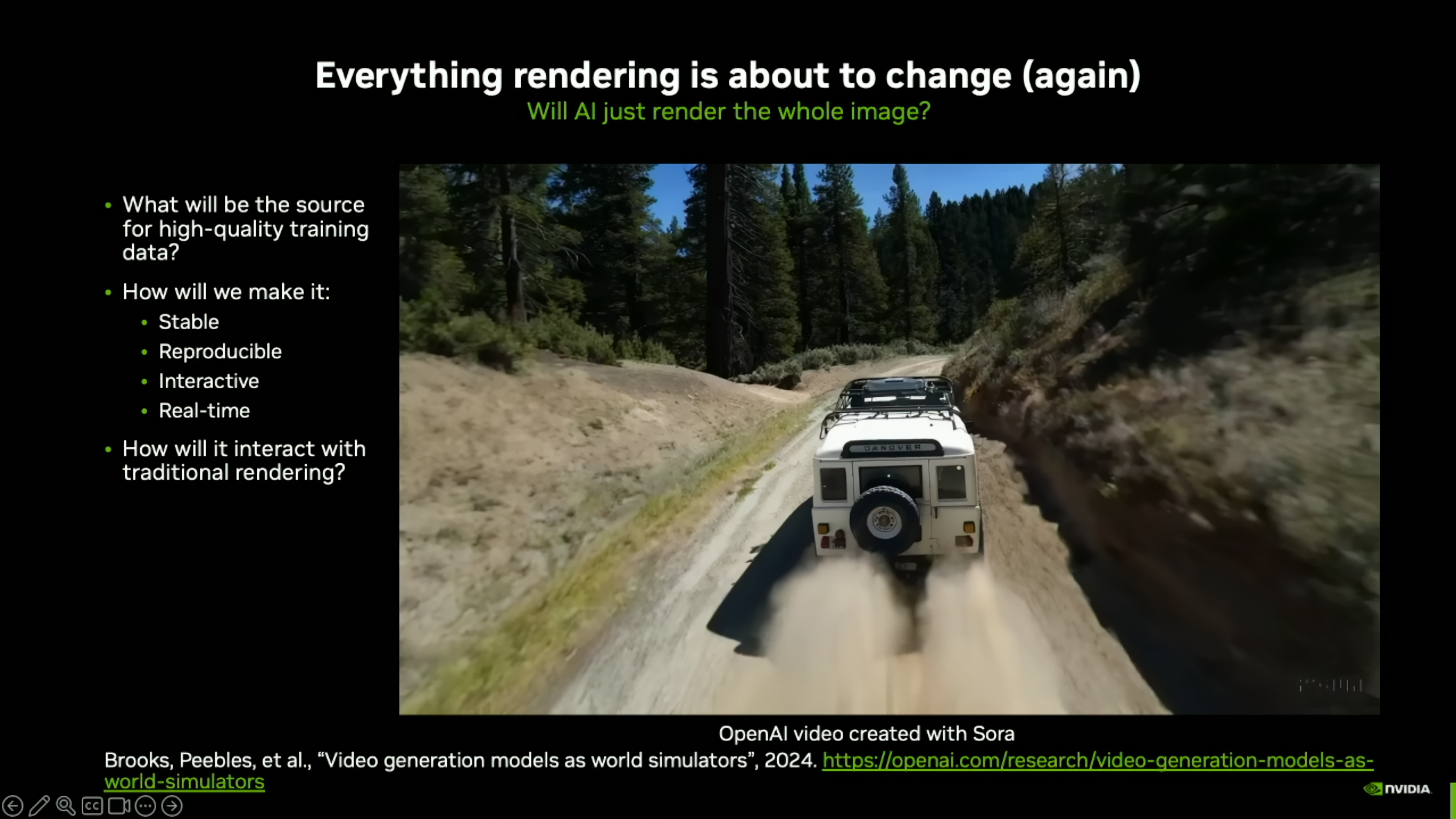

نمونهای از رندر آینده با هوش مصنوعی در قالب یک ویدیوی OpenAI اخیر که با استفاده از Sora ایجاد شده است به نمایش گذاشته شد که نشان میدهد یک جیپ در حال دویدن از میان یک زمین ناهموار خاکی با یک دنباله گرد و غبار واقع گرایانه است که پشت سر گذاشته شده است و خودرو وزن واقعی و مبتنی بر شبیهسازی را به نمایش میگذارد. در زمین این یک ویدیو کاملاً با هوش مصنوعی است که به ما نگاهی اجمالی به کاربردهای آینده هوش مصنوعی مانند بازی ها می دهد. این انیمیشن کوچک به 10 هزار پردازنده گرافیکی نیاز داشت تا با استفاده از یک پیام متنی کوچک آموزش داده شود، اما با قویتر شدن سختافزار هوش مصنوعی، احتمالاً میتوانیم در سالهای آینده شاهد آمدن آن به پردازندههای گرافیکی مصرفکننده باشیم.

از دیگر برداشتهای جالب از جلسه، نظرات مربوط به استفاده از سختافزار اختصاصی مانند NPU در مقابل GPU و نظرات در مورد دیگر شتابدهندههای آینده است که ممکن است در GPUهای آینده ادغام شوند:

مشکلی که من در مورد سخت افزار اختصاصی که به GPU متصل نیست می بینم این است که کل اکوسیستمی را از دست می دهید که می توانید از آن برای انجام تمام کارهایی که در اطراف شبکه های عصبی استفاده می کنید استفاده کنید. به همین دلیل است که ما ترجیح میدهیم آن را کاملاً به هم متصل کنیم تا بتوانید کدهای قابل برنامهریزی را روی یک SM انجام دهید، سپس به هسته تانسور بروید و هر چند وقت یکبار برای مشکل خاص خود نیاز دارید به عقب برگردید تا کسی بتواند سختافزار اختصاصی خود را بسازد. که فقط رمزگذارهای کانولوشنال را اجرا کرد، اما چگونه می توانید تمام کارهای دیگری را که باید انجام دهید انجام دهید.

من نمیخواهم در مورد هیچ محصول آینده یا چیزی صحبت کنم، اما تا زمانی که دیدم مدلهای ظاهر عصبی شروع به شکلگیری و کار کردند، زمان زیادی را صرف فکر کردن درباره چگونگی سرعت بخشیدن به مواد کردم، مثلاً اگر یک ماده شگفتانگیز Uber وجود داشته باشد. آرنولد شیدر را میشناسید، میدانید که میتواند چیزهای پیچیدهای را با 50 ورودی بگیرد و سختافزار اختصاصی بسازد که فقط از طریق آن منفجر شود یا چند لایه را با مونت کارلو یا چیزی که میشناسید نمونهبرداری کند، مونت کارلو را بدون موقعیت قرار دهد، و اساساً به جایی نرسید. اما من فکر میکنم که اختلال بعدی آشکاری وجود ندارد که از سختافزار اختصاصیافتهای که بتوانم ببینم ایجاد شود. من فکر میکنم اختلال بعدی مربوط به استفاده از عوارضی است که ما به تازگی فعال کردهایم تا قدم بعدی را بدون نیاز به سختافزار برداریم، زیرا سختافزار در حال حاضر بلوکهای ساختمانی را تسریع میکند که میتوانیم چیزی جدید و هیجانانگیز بسازیم. و من فکر میکنم مدلهای ظاهر عصبی نمونه خوبی برای آن است، ما قبلاً سختافزار را ساختهایم، فقط تا زمانی که آن را امتحان نکردیم نمیدانستیم که برای آن خوب است.

جان برگس – NVIDIA

به جرات می توان گفت که تأثیر هوش مصنوعی بر دنیای محاسبات هنوز قابل اندازه گیری نیست، با توجه به اینکه این فناوری امکانات بی پایانی را ارائه کرده است و تأثیر آن بر محاسبات گرافیکی نمونه کوچکی از قابلیت های بالقوه است. با مدلهای ظاهر عصبی و بازسازی پرتو، گرافیکهای نسل بعدی مطمئناً به نقطهای میرسند که زمانی آرزوی آن را داشتیم، و این به تلاشهای انویدیا و تیمش میپردازد، البته به نقشی که قدرت سختافزار در اینجا ایفا میکند.